El aumento de la competencia fue evidente el martes cuando Amazon anunció la disponibilidad de su nuevo chip de inteligencia artificial Trainium 2 y servicios informáticos basándose en testimonios de usuarios potenciales, incluido Apple. La empresa también presentó ordenadores que contienen 16 o 64 chips, con conexiones de red ultrarrápidas, que aceleran especialmente el rendimiento de las inferencias.

Amazon incluso está construyendo su propia fábrica gigante de inteligencia artificial para la startup Anthropic, en la que invirtió, dijo Matt Garman, director ejecutivo de Amazon Web Services. Este “clúster” informático tendrá cientos de miles de nuevos chips Trainium y será cinco veces más potente que cualquier chip que Anthropic haya utilizado, dijo Tom Brown, cofundador y director informático de la startup que ejecuta el chatbot Claude. y ubicado en San Francisco.

Se espera que el nuevo chip de inteligencia artificial MI300 de AMD genere más de 5 mil millones de dólares en ventas en su primer año de lanzamiento.Crédito: AHORA

“Esto significa que los clientes obtienen más inteligencia a un costo menor y a una velocidad más rápida”, afirmó Brown.

Se espera que el gasto total de los operadores de centros de datos en computadoras sin chips Nvidia, que proporcionan la potencia informática necesaria para las tareas de IA, crezca un 49 por ciento a 126 mil millones de dólares este año, según la firma de investigación de mercado Omdia.

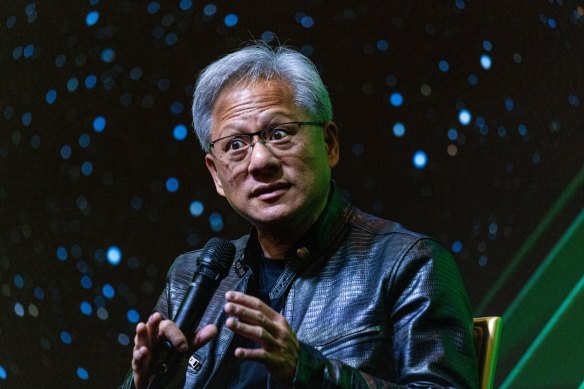

Aún así, una mayor competencia no significa que Nvidia esté en peligro de perder su liderazgo. Un portavoz de la empresa citó al director ejecutivo de Nvidia, Jensen Huang, diciendo que su empresa tiene importantes ventajas en software de inteligencia artificial y capacidades de inferencia. Huang añadió que la demanda es fuerte para los nuevos chips Blackwell AI de la compañía, que, según él, realizarán más cálculos por vatio de energía a pesar de la mayor potencia necesaria para funcionar.

Cargando

“Nuestro coste total de propiedad es tan bueno que incluso si los chips de la competencia son gratuitos, no son lo suficientemente baratos”, dijo Huang en un discurso en la Universidad de Stanford este año.

El cambiante mercado de chips de IA ha sido impulsado en parte por nuevas empresas bien financiadas como SambaNova Systems, Groq y Cerebras Systems, que recientemente han afirmado enormes ventajas de velocidad en inferencia con bajo costo y bajo consumo de energía. Los chips actuales de Nvidia pueden costar 15.000 dólares cada uno, mientras que se espera que los chips de Blackwell cuesten decenas de miles de dólares.

Esto ha llevado a algunos clientes a buscar alternativas. Dan Stanzione, director ejecutivo del Centro de Computación Avanzada de Texas, dijo que la organización planea comprar una supercomputadora basada en Blackwell el próximo año, pero los chips sambaNova también se pueden usar para la detección de tareas debido a su bajo consumo de energía y bajo costo.

“Esto es muy caro”, dijo sobre los chips de Nvidia.

AMD dijo que espera apuntar a los chips Blackwell de Nvidia con sus nuevos chips AI el próximo año. Mientras prueba completamente sus chips de IA en los laboratorios de la compañía en Austin, los ejecutivos dicen que el juicio sobre el desempeño es un punto de venta clave. Uno de los clientes es Meta, el propietario de Facebook e Instagram, quien dice que entrenó un nuevo modelo de IA llamado Llama 3.1 405B usando chips Nvidia, pero usa chips AMD MI300 para responder a los usuarios.

Jensen Huang convirtió a Nvidia en la empresa más valiosa del mundo.Crédito: Bloomberg

Amazon, Google, Microsoft y Meta también están construyendo grandes grupos de máquinas impulsadas por chips Nvidia, y todos diseñan sus propios chips de inteligencia artificial para acelerar la computación de precisión y lograr costos más bajos. Este mes, Google planea comenzar a vender servicios basados en la sexta generación de chips desarrollados internamente llamados Trillium, que es aproximadamente cinco veces más rápido que el anterior.

Amazon, que a veces se queda atrás en IA, parece especialmente decidida a ponerse al día. La compañía ha gastado 75 mil millones de dólares este año en chips de inteligencia artificial y otro hardware informático, incluidos gastos de capital.

En las oficinas de la compañía en Austin, dirigidas por Annapurna Labs, una startup que adquirió en 2015, los ingenieros desarrollaron previamente chips de red y microprocesadores de uso general para Amazon Web Services. Sus primeros chips de IA, incluida la primera versión de Trainium, no ganaron mucho terreno en el mercado.

Cargando

Amazon es muy optimista acerca de los nuevos chips Trainium 2, que son cuatro veces más rápidos que los chips anteriores. El martes, la compañía anunció planes para otro chip, el Trainium 3, que se suponía sería aún más potente.

Eiso Kant, director de tecnología de la startup de inteligencia artificial Poolside, con sede en París, estima que Trainium 2 ofrece una mejora del 40 por ciento en el rendimiento informático por dólar en comparación con el hardware basado en Nvidia.

Amazon también planea ofrecer servicios basados en Trainium en centros de datos de todo el mundo, añadió Kant, lo que ayudará con la identificación de empleos.

“La verdad es que, en mi negocio, no me importa lo que haya debajo del silicio”, dijo. “Lo único que me importa es conseguir el mejor precio y poder entregárselo al usuario final”.

Este artículo apareció originalmente. Los New York Times.

El boletín Business Briefing proporciona eventos clave, cobertura exclusiva y opiniones de expertos. Regístrate para recibirlo todas las mañanas.